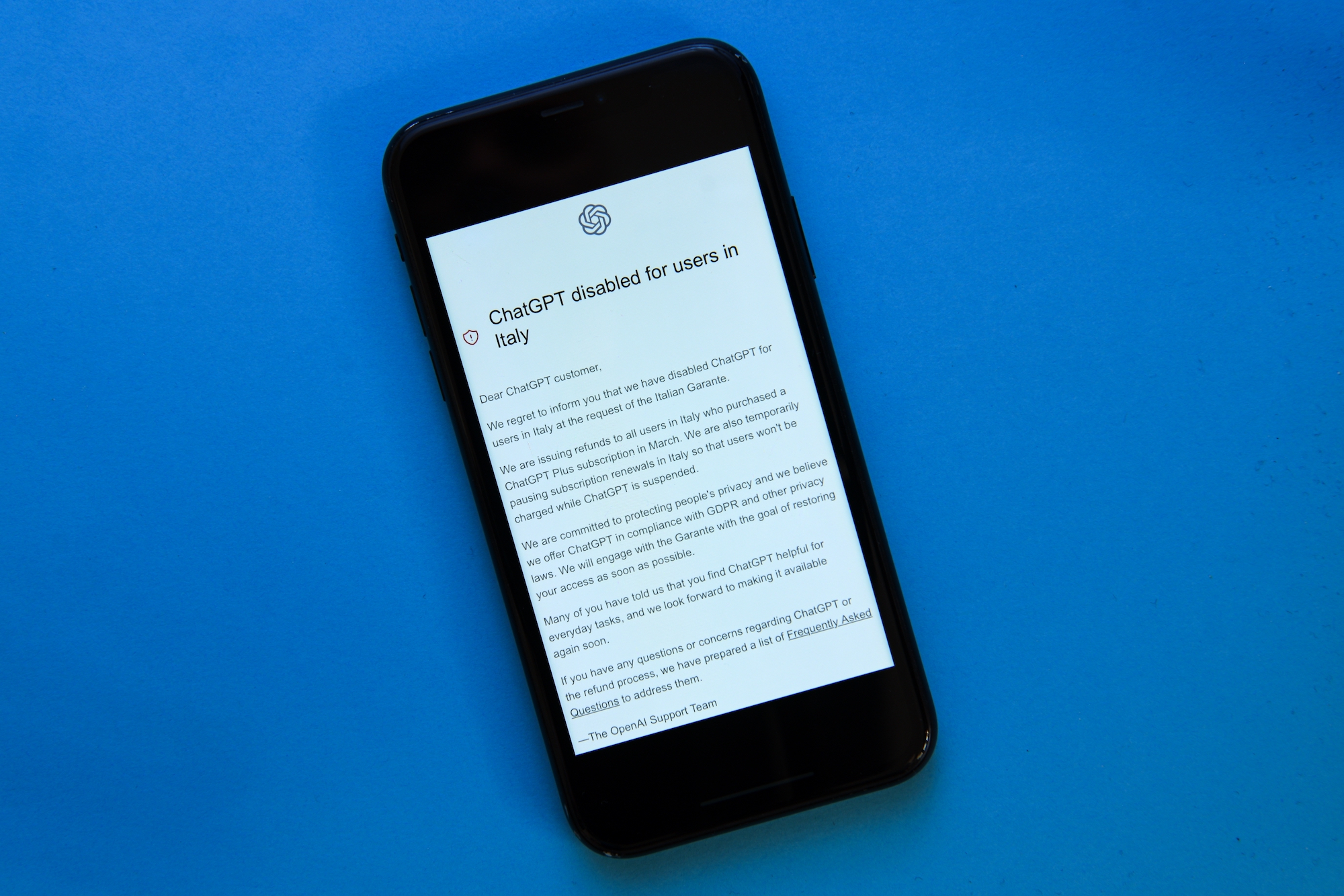

Immagina di accedere al tuo strumento aziendale più prezioso quando arrivi al lavoro e di essere accolto da questo:

“ChatGPT disabilitato per gli utenti in Italia

Gentile cliente ChatGPT,

Siamo spiacenti di informarti che abbiamo disabilitato ChatGPT per gli utenti in Italia su richiesta del Garante Italiano.

OpenAI ha dato questo messaggio agli utenti italiani a seguito di a indagine dal Garante per la protezione dei dati personali. Il garante citato violazioni specifiche come segue:

- OpenAI non ha informato adeguatamente gli utenti che stava raccogliendo dati personali.

- OpenAI non ha fornito alcun motivo legale per raccogliere informazioni personali per addestrare il suo algoritmo.

- ChatGPT elabora le informazioni personali in modo impreciso senza utilizzare fatti reali.

- OpenAI non richiede agli utenti di verificare la propria età, anche se i contenuti generati da ChatGPT sono destinati agli utenti circa 13 anni e richiede il consenso dei genitori per i minori di 18 anni.

In effetti, un intero Paese perde l’accesso a una tecnologia ampiamente utilizzata perché il suo governo teme che i dati personali vengano gestiti in modo inappropriato da un altro Paese e che la tecnologia non sia sicura per un pubblico più giovane.

Diletta De CiccoL’avvocato milanese in materia di privacy dei dati, sicurezza informatica e risorse digitali con Squire Patton Boggs, ha osservato:

“Non sorprende che la decisione del Garante sia arrivata subito dopo che una violazione dei dati ha colpito le conversazioni degli utenti e i dati forniti a OpenAI.

Inoltre, arriva in un momento in cui l’intelligenza artificiale generativa si sta facendo strada verso il mainstream a un ritmo rapido (e non viene adottata solo da utenti esperti di tecnologia).

Un po’ più sorprendentemente, mentre il comunicato stampa italiano fa riferimento al recente episodio di violazione, non vi è alcun riferimento ad esso nella decisione italiana per giustificare il divieto temporaneo, che si basa su: dati inesatti, mancanza di informazioni degli utenti e delle persone in generale, mancanza di verifica dell’età dei bambini e mancanza di base giuridica per i dati sulla formazione.

Sebbene OpenAI LLC operi negli Stati Uniti, deve rispettare la normativa italiana Codice in materia di protezione dei dati personali perché elabora e archivia le informazioni personali degli utenti in Italia.

Il Codice sulla protezione dei dati personali è stata la principale legge italiana in materia di protezione dei dati privati fino a quando l’Unione Europea non ha emanato il Regolamento generale sulla protezione dei dati (GDPR) nel 2018. La legge italiana è stata aggiornata per conformarsi al GDPR.

Cos’è il GDPR?

Il GDPR è stato introdotto con l’obiettivo di proteggere la privacy delle informazioni personali nell’UE. Le organizzazioni e le imprese che operano nell’UE devono rispettare le normative GDPR sul trattamento, la conservazione e l’utilizzo dei dati personali.

Se un’organizzazione o azienda ha necessità di trattare i dati personali di un utente italiano, deve rispettare sia il Codice in materia di protezione dei dati personali italiano sia il GDPR.

In che modo ChatGPT potrebbe violare le regole GDPR?

Se OpenAI non riuscisse a dimostrare la propria tesi contro il Garante italiano, potrebbe avviare un’ulteriore revisione per violazione delle linee guida GDPR riguardo a quanto segue:

- Negozi ChatGPT input dell’utente – che può contenere informazioni personali sugli utenti dell’UE (come parte del processo di formazione).

- OpenAI consente ai formatori per visualizzare le conversazioni ChatGPT.

- OpenAI consente agli utenti di eliminare i propri account ma afferma che non possono eliminare richieste specifiche. Rileva che gli utenti non dovrebbero condividere informazioni personali sensibili nelle conversazioni ChatGPT.

OpenAI fornisce basi legali per il trattamento delle informazioni personali degli utenti dello Spazio economico europeo (che comprende i paesi dell’UE), del Regno Unito e della Svizzera nella sezione nove dell’Informativa sulla privacy.

La pagina Termini di utilizzo definisce contenuto come input (il tuo prompt) e come output (la risposta generativa dell’IA). Ogni utente ChatGPT ha il diritto di utilizzare i contenuti generati utilizzando gli strumenti OpenAI per scopi personali e commerciali.

OpenAI informa gli utenti dell’API OpenAI che i servizi che utilizzano dati personali dei residenti nell’UE devono essere conformi al GDPR, al CCPA e alle leggi locali sulla privacy applicabili per i suoi utenti.

Man mano che ciascuna intelligenza artificiale si evolve, il contenuto generativo dell’intelligenza artificiale può contenere l’input dell’utente come parte dei suoi dati di addestramento, che possono includere informazioni personali sensibili degli utenti di tutto il mondo.

Rafi Azim KhanIl responsabile globale della privacy dei dati e del diritto di marketing presso Pillsbury Winthrop Shaw Pittman LLP, ha commentato:

“Le recenti proposte di legge in Europa (AI Act) hanno attirato l’attenzione, ma spesso può essere un errore trascurare altre leggi già in vigore che potrebbero essere applicabili, come il GDPR.

L’azione coercitiva dell’autorità di regolamentazione italiana contro OpenAI e ChatGPT questa settimana ha ricordato a tutti che leggi come il GDPR influiscono sull’uso dell’intelligenza artificiale.

Azim-Khan ha anche evidenziato potenziali problemi con le fonti di informazione e i dati utilizzati per generare risposte ChatGPT.

“Alcuni risultati dell’intelligenza artificiale mostrano errori, sollevando preoccupazioni sulla qualità dei dati estratti da Internet e/o utilizzati per addestrare la tecnologia”, ha osservato. “Il GDPR conferisce alle persone il diritto di correggere gli errori (come fa il CCPA/CPRA in California). »

Che mi dici del CCPA, comunque?

OpenAI affronta le preoccupazioni sulla privacy degli utenti della California nella sezione cinque del suo politica sulla riservatezza.

Divulga informazioni condivise con terze parti, inclusi affiliati, venditori, fornitori di servizi, forze dell’ordine e parti coinvolte in transazioni con prodotti OpenAI.

Queste informazioni includono le informazioni di contatto e di accesso dell’utente, l’attività di rete, i contenuti e i dati di geolocalizzazione.

In che modo ciò potrebbe influire sull’utilizzo di Microsoft in Italia e nell’UE?

Per rispondere alle preoccupazioni sulla privacy dei dati e sul GDPR, Microsoft ha creato il Centro fiducia.

Gli utenti Microsoft possono ottenere ulteriori informazioni su come vengono utilizzati i loro dati su Servizi Microsofttra cui Bing e Microsoft Copilot, che funziona con la tecnologia OpenAI.

Gli utenti dell’intelligenza artificiale generativa dovrebbero preoccuparsi?

“La cosa principale è questa [the Italian Garante case] potrebbe essere la punta dell’iceberg mentre altre agenzie di controllo esaminano più da vicino i modelli di intelligenza artificiale”, afferma Azim-Khan.

«Sarà interessante vedere cosa faranno le altre autorità europee per la protezione dei dati personali», se seguiranno subito il Garante o se adotteranno un approccio attendista – aggiunge De Cicco – Ci sarebbe stato da sperare in una risposta comune dell’Ue. a una questione così socialmente delicata”.

Se il Garante italiano vincesse la causa, altri governi potrebbero iniziare a indagare su più tecnologie – inclusi i colleghi e concorrenti di ChatGPT, come Google Bard – per vedere se violano linee guida simili sulla sicurezza dei dati personali e un pubblico più giovane.

“A quello italiano potrebbero seguire altri divieti”, afferma Azim-Khan. Come minimo, potremmo vedere gli sviluppatori di intelligenza artificiale costretti a raccogliere enormi set di dati e riqualificare i loro robot.

OpenAI ha recentemente aggiornato il suo blog con l’impegno a garantire sistemi di intelligenza artificiale sicuri.

Immagine in primo piano: Pcruciatti/Shutterstock