A proposito di immanenza

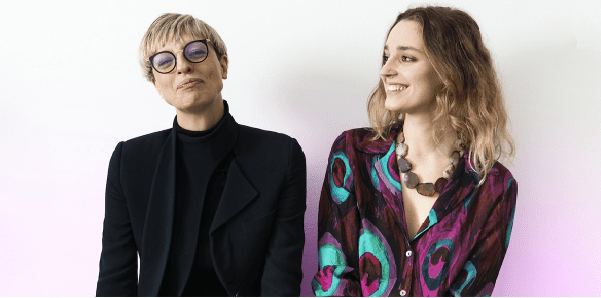

- Fondatori: Luna Bianchi, Dilletta Huyskes

- Fondato nel: 2023

- Dipendenti: 2

- I soldi raccolti: –

- Obiettivo finale: supportare le aziende tecnologiche rendendo l’etica dell’IA accessibile, modulare, personalizzata e facile da pianificare per rendere finalmente le aziende responsabili del proprio impatto, essendo l’etica un indicatore chiave delle prestazioni

L’immanenza è definita come “lo stato di essere presente come parte naturale e permanente di qualcosa”. Ed è così che l’etica dovrebbe trovare la sua strada nell’intelligenza artificiale, afferma Luna Bianchi, co-fondatrice dell’azienda che mira ad aiutare le imprese e i governi a rendere i loro sistemi di intelligenza artificiale il più etici possibile. : Immanenza. “Rispettosa delle persone, rispettosa di ciò che la circonda”, spiega.

L’intelligenza artificiale e l’etica dell’IA sono diventate l’argomento caldo dell’anno. Da quando ChatGPT è diventato pubblicamente disponibile, sono sorte domande: dovrebbe essere utilizzato nelle scuole? È un pericoloso creatore di fake news? Le domande sono molte. Perché, quando chiedi a Midjourney di disegnare una cameriera, è probabile che il software produca l’immagine di una donna non bianca? È importante porsi queste domande, ma è anche importante capire che si tratta di problemi specifici che derivano dalla stessa radice: l’intelligenza artificiale rafforza i pregiudizi umani, inclusi il razzismo e il sessismo. Tuttavia, solo perché i problemi hanno la stessa origine non significa che la soluzione sia universale.

Poco più di un anno fa nasceva a Roma il concept Immanence, che sta cercando di trovare un modo per rendere etici i sistemi di IA. Una delle loro fondatrici, Diletta Huyskes, aveva appena tenuto un discorso alla Camera dei Rappresentanti italiana. Era il 26 febbraio 2022, Luna Bianchi le si avvicinò e discussero l’idea. Un anno dopo, sono in affari con Immanence. Innovation Origins ha parlato con Luna Bianchi per capire la loro missione.

Come lavori?

“Vogliamo cambiare l’idea che i risultati della tecnologia dipendano da come la usiamo. Oggi dipendono maggiormente da come li creiamo. Ecco perché aiutiamo le aziende a configurare i loro algoritmi. Si può intervenire anche dopo – noi la chiamiamo “manutenzione etica” – ma prevenire è meglio che curare. Attualmente, non c’è molta legislazione sugli algoritmi AI. A livello internazionale, si tratta principalmente di soft law ed è visto come una lista di controllo a cui devi aderire, non qualcosa di fondamentale.

Sembra che Immanence sia una società di consulenza, anche se non hai mai usato quella parola. È corretto?

“Se vogliamo inquadrarlo in un tipo di servizio a cui siamo abituati, dovremmo chiamarlo effettivamente consulenza. Ma non mi piace molto questo termine perché sembra che ti stia dicendo come fare qualcosa e solo per risolvere un problema che hai. Quello che facciamo, tuttavia, è ragionare di più e trovare potenziali problemi che gli imprenditori a volte non sanno di avere. Guidiamo e spieghiamo, invece di limitarci a risolvere. Creiamo nella mente dell’imprenditore una comprensione dell’etica nella tecnologia e del motivo per cui tutti ne abbiamo bisogno. Quindi sì, tecnicamente è una società di consulenza. Ma penso che un termine più corretto sia “co-design”.

Chi dovrebbe determinare il codice morale dell’intelligenza artificiale? – Origini dell’innovazione

L’etica dell’IA è un argomento controverso, per non dire altro. Chi dovrebbe determinare il suo codice morale?

Che metodo segui?

“Seguiamo le aziende dall’inizio del loro sviluppo. Ci piace confrontarci con i diversi reparti dell’azienda per capire qual è la priorità di ciascuno. A livello pratico, alcune aziende chiedono semplicemente una revisione etica, che è – tornando alla domanda precedente – molto simile a una società di consulenza. Ma il fulcro del nostro lavoro è fornire alle aziende la possibilità di esternalizzare lo sviluppo dell’etica dell’IA. Ci occupiamo di questo continuamente per tutto il tempo che l’azienda desidera. E valutiamo la situazione ogni volta che qualcosa cambia. Come quando l’azienda riceve notifiche dagli utenti, se cambiano l’algoritmo o se assumono qualcuno di nuovo per una determinata posizione. Sta arrivando una legge europea, e noi stiamo cercando di anticiparla. A questo punto non posso dire molto su questioni specifiche poiché stiamo appena iniziando tutti i nostri progetti. In ogni caso, i nostri esperti esaminano l’algoritmo e determinano se è adatto al business. Successivamente, determiniamo quale modello di intelligenza artificiale potrebbe funzionare meglio. Ad esempio, a volte le persone scelgono l’apprendimento automatico senza pensarci troppo. Ma non ne hanno necessariamente bisogno, e questo significa che devono impegnarsi di più per controllarlo rispetto a qualsiasi altro modello. Cerchiamo anche chi ha sviluppato l’algoritmo, chi lo ha testato e, naturalmente, esaminiamo i set di dati per assicurarci che siano corretti per le persone. Vogliamo assicurarci di valutare tutti i potenziali problemi, nonché le soluzioni e le conseguenze. »

Hai detto che c’è un malinteso comune sull’etica dell’IA, quale?

“Tutti noi tendiamo a pensare all’etica dell’IA come a qualcosa di generale. Come se si applicassero sempre principi uguali per tutti. E questo è vero fino a un certo punto. Ciò che dimentichiamo, però, è quanto l’IA dipenda dal contesto e dall’input umano, e quanto velocemente questo mondo sta cambiando. I sistemi cambiano, il contesto cambia e la coscienza delle persone cambia. Ecco perché non puoi fare affidamento su formule fisse, ma devi costantemente controllare e adattarti. L’etica dovrebbe essere presente nell’IA come parte integrante di essa Ecco perché abbiamo chiamato la nostra azienda “Immanenza”.

“ChatGPT è solo la punta dell’iceberg, la maggior parte del potenziale dell’IA è ancora sott’acqua”